ESPACES FIBRÉS

et

CONNEXIONS

Une introduction aux géométries

classiques et quantiques

de la physique théorique

Robert Coquereaux

Centre de Physique Théorique

Luminy - Marseille

A mes enfants Valérie, Eric et Raphaël

Il est quelquefois plus facile de présenter un livre en disant ce qu’il n’est pas et en dressant une liste des motivations de l’auteur qu’en essayant d’en expliciter le contenu.

Ce livre, bien qu’il contienne un exposé de géométrie différentielle (avec un accent particulier mis sur les groupes de Lie, la théorie des espaces fibrés, la théorie des connexions et la géométrie riemannienne) n’est certainement pas un cours de mathématiques traditionnel. En général les mathématiciens cultivent la précision du style et la concision du discours, alors que l’exposé qui suit essaye de présenter les idées importantes en faisant souvent appel à l’intuition, en effectuant de nombreux retours en arrière et en ne négligeant pas les clins d’oeil à la physique. On peut donc espérer que la lecture de l’ouvrage présent sera un peu moins aride que celle d’un traité traditionnel.

Ce livre n’est pas non plus un cours de physique théorique. Il y manque beaucoup trop d’informations ! Celui ou celle qui souhaite se lancer à la découverte de l’Espace-Temps et déchiffrer certains des mystères de notre univers devrait s’attaquer à de saines lectures (par exemple [5]). L’ouvrage présent ressemble plus à un cours de mathématiques qu’à un cours de physique ; la physique n’est cependant pas absente, au contraire : des idées physiques sont cachées derrière chaque paragraphe, et ce sont elles qui sont, la plupart du temps, à l’origine des notions “abstraites” que nous allons présenter.

Bien qu’il ne s’agisse pas là d’un ouvrage de vulgarisation sur la physique théorique ou les mathématiques, j’ai pourtant rédigé de nombreux paragraphes en pensant à certains de mes amis ayant une culture mathématique relativement modeste mais néanmoins dotés d’un esprit curieux et aimant vagabonder de temps à autres sur des terrains situés au confluent de l’infiniment petit, de l’infiniment grand, des mathématiques et de la métaphysique. Je dois dire, en relisant l’ouvrage après coup, que, de ce point de vue, j’ai peur d’avoir echoué : le contenu présenté ressemble plus à un cours de troisième cycle spécialisé qu‘à un ouvrage de vulgarisation… Cela dit, je pense — et j’espère — qu’à la condition de commencer la lecture à la première page sans essayer de démarrer en plein milieu, l’ouvrage reste accessible à tout lecteur disposant d’un bagage mathématique équivalent à celui qu’on est censé acquérir à l’issue d’un premier cycle universitaire, ou d’une classe de Mathématiques Spéciales. A propos de motivations, je dois aussi signaler que d’autres de mes amis, dotés d’une culture mathématique plus que respectable n’ont malheureusement jamais eu le temps ou la patience de traduire le jargon quelquefois flou des physiciens dans la langue bourbakiste qu’ils affectionnent. Le présent ouvrage, bien que résolument peu bourbakiste dans le style, est également écrit pour eux. Finalement, ce livre est également —et probablement surtout— écrit pour les étudiants en mathématiques ou en physique, mais qu’on ne vienne pas me demander “De quelle année ?” ! En effet, certains des thèmes qui seront abordés peuvent être rencontrés dans un cours de maîtrise de mathématiques (ou de DEA) et on les trouvera souvent incorporés à un enseignement de troisième cycle de physique théorique ou de géométrie différentielle, mais d’autres thèmes, probablement aussi intéressants, et quelquefois même fondamentaux, risquent fort de ne figurer dans le programme d’aucun enseignement universitaire. L’étudiant, physicien ou mathématicien, trouvera peut-être, dans cet ouvrage, ce qu’il cherche (en utilisant l’index et la table des matières) et le non-spécialiste y trouvera peut-être ce qu’il ne cherchait pas…

Enfin, ce livre n’est pas un ouvrage de philosophie ou de métaphysique (Dieu m’en garde !) bien que certaines réflexions de nature éminemment philosophiques ne soient pas absentes des pages qui suivent, surtout dans la section Introduction.

La partie “géométrie différentielle” de ce travail est issue d’un cours de troisième cycle que j’ai eu l’occasion de donner pendant plusieurs années au sein du Diplôme d’Etudes Approfondies (DEA) de Physique Théorique, organisé au Centre de Physique Théorique, à Luminy (Marseille) ainsi qu’en 1997, dans le DEA de Physique Théorique organisé à l’Ecole Normale Supérieure de Lyon. La partie “non commutative” (la dernière section) est un court extrait d’une série de cours que j’ai donnés dans les universités de Rio de Janeiro (URJ, UFRJ et CBPF), de Saragosse et de La Plata ainsi qu’à San Carlos de Bariloche, en 1996 et 1997. L’ouvrage a également servi de support à un cours semestriel de l’IMPA, Rio de Janeiro, en 2012 (Pós-Graduação em Matemática, curso de Doutorado).

Qu’est ce que la “Réalité” ? Existe-t-elle seulement ? Que signifie le verbe “exister” de la proposition interrogative précédente ? Que le lecteur allergique aux discussions philosophiques se rassure, nous n’allons pas continuer longtemps dans cette direction. Cependant, pour ne pas nous enliser dans de faux problèmes sémantiques et pour bien apprécier en quel sens nous comprenons ou prétendons comprendre les phénomènes naturels (y en a-t-il qui ne le soient pas ?) il nous faut apporter une réponse pragmatique aux questions précédentes et tenter de définir les mots eux-mêmes que nous utilisons.

Le point de vue adopté par l’auteur est le suivant :

∙ Il est impossible de donner une signification quelconque à la phrase suivante : La Réalité est. L’auteur croit cependant en l’existence d’une réalité objective dont la nature est indépendante de l’analyse qui peut en être faite. Malheureusement, il s’avère également impossible de donner un sens raisonnable à l’assertion précédente. La croyance de l’auteur est donc un acte de foi au sens métaphysique du terme. On pourra donc utiliser le mot “phénomène” comme synonyme du mot “réalité”, le vocable en question étant lui-même non défini.

∙ La description d’un phénomène, quel qu’il soit, fait toujours appel aux mathématiques, même si le spectateur n’en est pas conscient. Ainsi, déclarer que deux individus font partie de la même lignée (au sens héréditaire du terme) signifie qu’on assimile –peut être inconsciemment– les individus en question aux éléments d’un ensemble sur lequel on a défini une relation d’ordre partiel. De la même façon, la traversée d’un terrain par un ballon de foot-ball est un phénomène admettant une description (en fait plusieurs) dont la nature est essentiellement mathématique. Par exemple, on peut considérer la trajectoire d’un point traversant un rectangle en ligne droite. Il existe cependant une description du même phénomène ou le ballon n’est plus un point mais une sphère et ou le terrain n’est plus assimilé à un rectangle mais une figure géométrique plus complexe (coins plus ou moins arrondis, côtés plus ou moins parallèles etc.) On peut d’ailleurs continuer dans ce sens et tenir en compte l’existence de creux et de bosses sur la surface du ballon, de la couleur etc. Les humains n’ont pas besoin de suivre des cours de mathématiques supérieures pour apprécier un match de foot-ball, mais il est important de constater l’aptitude de l’esprit à créer inconsciemment des modèles mathématiques relativement élaborés pour analyser l’expérience quotidienne. Notons enfin qu’un phénomène donné possède d’ordinaire plusieurs descriptions mathématiques (et même une infinité).

∙ La croyance en l’existence d’une réalité objective n’a aucune importance pratique ; seule compte l’ensemble de ses descriptions mathématiques. En effet, lors de l’analyse d’un phénomène (la traversée de la cour par un ballon de foot-ball), nous pouvons adopter les deux points de vue suivants. 1) La traversée de la dite cour par le ballon en question est un phénomène “réel” dont nous pouvons donner une quantité de descriptions mathématiques compatibles, et il est d’ailleurs possible de préciser la notion de compatibilité des descriptions. 2) La traversée de la dite cour par le ballon en question est en fait définie par un ensemble (infini) de descriptions mathématiques compatibles. Peu importe que nous adoptions l’un ou l’autre de ces deux points de vue, car si un aspect d’un phénomène n’est pas mathématiquement modèlisable, cet aspect relève –presque par définition– de la métaphysique et il n’est pas clair qu’on puisse y attribuer un sens (même si on a envie de croire sans comprendre). On peut se convaincre du fait que l’exercice classique de méditation sur le thème de la chaise (Quelle est cette chaise ? Quelle est sa fonction ? Quelle est sa nature ? Quelle est son histoire ? etc.) est complètement modèlisable en termes mathématiques...

Pour nous, un phénomène est donc défini par l’ensemble de ses descriptions mathématiques. Du point de vue linguistique, on devrait peut-être distinguer en général le phénomène lui-même (concept assez flou) de sa description mathématique – ou plutôt, de ses descriptions mathématiques. On peut alors parler de modélisation du phénomène, mais il faut bien voir que c’est la modélisation elle-même qui rend le phénomène accessible à l’analyse. Le modèle mathématique, qu’il soit choisi consciemment (par un physicien, par exemple) ou inconsciemment (par exemple, par un spectateur du match) apporte avec lui son propre langage, c’est à dire les mots qui permettent à l’observateur de se poser des questions à propos du phénomène qu’il contemple. Chacun de ces mots est censé être susceptible d’une traduction mathématique précise dans un cadre formel — que l’observateur ne défini pas nécessairement — faute de quoi, les mots en question sont simplement vides de sens. Il faut bien être conscient du fait que la phrase “mais que se passe-t-il vraiment ?” posée par le profane repose sur la croyance en une réalité objective, réalité qui, de notre point de vue, échappe à toute analyse scientifique.

Qu’en est-il donc de la distinction entre physique et mathématiques ? Pour nous, dire qu’une figure dessinée sur une feuille de papier est un triangle, c’est “faire de la physique” : le triangle est une notion abstraite appartenant au monde des mathématiques, associer cette notion au dessin qu’on a sous les yeux est un travail de physicien. Dans un genre différent, supposons qu’on fabrique des “choses” avec un canon à électrons… qu’est ce donc qu’un électron ? On peut dire que c’est une petite boule, on peut dire que c’est une fonction (complexe) –une onde !–, on peut dire que c’est une section d’un certain espace fibré vectoriel (un “champ de Dirac”) ou que c’est un élément d’un module projectif de type fini sur une algèbre non nécessairement commutative… Toutes ces descriptions sont mathématiques et la première (la boule) est la plus simple du point de vue du bagage mathématique utilisé mais toutes ces descriptions sont également “vraies” et apportent avec elles leur propre langage. Il y a des questions qu’on ne peut poser qu’après avoir choisi une certaine description. C’est ainsi que les mathématiques sont nécessaires à la description de ce que nous appelons les phénomènes naturels (conséquence immédiate : si vous avez des difficultés en physique, c’est que vous n’avez pas proprement assimilé les mathématiques nécessaires !). La physique consiste essentiellement à habiller le phénomène de notre choix avec des mathématiques appropriées et c’est cet habillage qui rend les choses accessibles au discours. C’est là quelque chose qu’il ne faut pas oublier mais il faut avouer qu’il est néanmoins commode de vivre en faisant “comme si” on croyait à l’existence d’une réalité objective ! On pourrait aussi passer au cran supérieur et se demander si les mathématiques elles-mêmes “existent”. Il n’est pas clair que la phrase ait un sens mais il est certain que, de la même façon qu’il est commode de croire en l’existence d’une réalité physique objective, il est également commode de croire en l’existence d’une réalité mathématique qu’il s’agit pour nous de découvrir (comme un explorateur dans la jungle ou comme un physicien expérimentateur). Les chapitres qui suivent présentent des concepts mathématiques. Indépendamment de la beauté ou de l’élégance intrinsèque des concepts en question, nous voulons attirer l’attention du lecteur (même s’il n’est pas physicien) sur le fait que ces concepts jouent un rôle majeur dans l’“habillage” contemporain des théories physiques, et que, dans de nombreux cas, ces concepts sont eux-mêmes issus de considérations relevant de la physique théorique.

Avant d’arrêter là ces considérations épistémologiques pour passer à notre premier chapitre consacré à l’étude des variétés différentiables, nous voulons dire un mot sur la distinction entre physique classique et physique quantique, en parallèle avec la distinction entre “mathématiques commutatives” et “mathématiques non commutatives”. Cette remarque risque de n’être comprise que par les lecteurs ayant déjà une certaine familiarité avec les sujets mentionnés mais le lecteur intéressé pourra peut-être relire ce commentaire en y revenant un peu plus tard. Les mathématiques commutatives (la géométrie commutative en particulier) s’occupe des propriétés mathématiques des “espaces” (théorie de la mesure, espaces topologiques, différentiables, riemanniens, homogènes, possédant une structure de groupe…) Pour le physicien, ces espaces fournissent un modèle mathématique concernant le système qu’il a choisi d’étudier et toutes les quantités qui l’intéressent peuvent être décrites à l’aide d’une classe appropriée de fonctions définies sur de tels espaces. Il se trouve que les propriétés des espaces en question peuvent elles-mêmes être codées en termes des propriétés de ces algèbres de fonctions ; il s’agit là d’un résultat profond dont l’expression précise est due à Gelfand (voir chapitre 6). Le vocable “mathématiques commutative” vient du fait que toutes ces algèbres sont des algèbres commutatives pour les lois d’addition et de multiplication des fonctions. Attention, de ce point de vue, la théorie des groupes de Lie (voir plus loin) –groupes qui ne sont pas, en général, commutatifs– fait partie des “mathématiques commutatives” car l’algèbre des fonctions (à valeurs réelles ou complexes) définie sur un groupe est une algèbre commutative ! Les “mathématiques non commutatives”, au contraire, s’occupent des propriétés d’algèbres qui ne sont pas commutatives et des objets qui généralisent les constructions usuelles lorsqu’on remplace les algèbres de fonctions (et les “espaces” eux-mêmes) par des algèbres d’opérateurs. Les quantités qui intéressent le physicien ne sont plus alors codées par des fonctions numériques mais, typiquement, par des opérateurs agissant dans des espaces hilbertiens. Il est inutile d’en dire plus à ce niveau mais nous effectuerons deux remarques. La première est terminologique : un physicien dit qu’il fait de la physique classique lorsqu’il utilise des mathématiques commutatives pour décrire un phénomène (ce qui, philosophiquement, revient à le définir ! Voir la discussion précédente) et de la physique quantique lorsqu’il utilise des mathématiques non commutatives (idem). La seconde remarque a trait au contenu de cet ouvrage : il traite de géométrie, et la plupart du temps de géométrie utilisée en physique fondamentale, cependant il s’agira presque toujours de géométrie commutative, vocable englobant d’ailleurs toute la géométrie, au sens usuel du terme, qu’elle soit euclidienne ou non. Du point de vue de la physique, nos constructions correspondront donc à des constructions de théorie classique des champs (même s’il nous arrive de parler de quarks ou d’électrons de Dirac) et non de théorie quantique des champs.

Le dernier chapitre est une introduction aux “mathématiques non commutatives” (un point de vue assez particulier sur la théorie des algèbres associatives) et présente quelques notions fondamentales relevant de le géométrie différentielle non commutative. Ce dernier chapitre pourrait donc aussi s’intituler : Introduction à la géométrie quantique.

Le lecteur ne connaissant rien au sujet et désirant “se faire une idée”, peut dans un premier temps, parcourir les sections 1.1, 1.2, 2.1, 2.2.1, ainsi que 3.1, (3.2.1 → 3.2.5), 3.3.1, 3.3.2, (4.1.1 → 4.1.4) et (4.4.1, 5.6.1, 6.1, 6.2.1, 6.3.1) dont le contenu, à peu près exempt de formules, fait appel à l’intuition et ne suppose que très peu de connaissances préalables.

Les autres sections sont assez inégales ; certaines présentent un matériel qui fait ou devrait faire partie du bagage mathématique standard de tout mathématicien ou physicien théoricien, certaines autres sont d’un niveau plus avancé et peuvent contenir des informations qui ne sont pas nécessairement disponibles ailleurs (sauf peut-être dans quelques articles spécialisés). En fait, comme le titre l’indique, le but initial de ce travail était de fournir une présentation — si possible pédagogique — des espaces fibrés et de la théorie des connexions. Il se trouve que certains lecteurs potentiellement intéressés, en particulier les étudiants de troisième cycle de physique théorique, n’ont souvent pas, au départ, les bases mathématiques nécessaires pour attaquer, de front, un cours relativement complet sur les espaces fibrés : il leur manque souvent un cours préalable de calcul différentiel sur les variétés et un cours sur les groupes de Lie. C’est la raison d’être des parties 1 et 2 de cet ouvrage. On a essayé d’y présenter les notions indispensables à la lecture des chapitres 3 et 4 consacrés aux espaces fibrés et à la théorie des connections. Nous suggérons donc à ceux qui ont déjà acquis une formation raisonnable en ce qui concerne les variétés différentiables (par exemple en lisant le premier volume de [13] et les groupes de Lie, de jeter d’abord un coup d’œil au sommaire, puis de sauter les deux premiers chapitres — qui ne leur apprendront sans doute pas grand chose — et d’entamer directement la lecture de cet ouvrage au chapitre 3. Pour les autres… il vaudrait peut-être mieux s’astreindre à lire les différentes parties dans l’ordre. Comme nous l’avons mentionné dans la préface, l’ensemble de l’ouvrage devrait être lisible par quelqu’un ne disposant pas d’un bagage mathématique supérieur à celui qu’on acquiert d’ordinaire, ou qu’on est sensé acquérir, en premier cycle. Son contenu, néanmoins, serait plutôt d’un niveau 3èmecycle.

Le plan et la structure de ce livre répond à la préoccupation suivante : faire du lecteur un “honnête homme” en géométrie différentielle classique en présentant un certain nombre de notions qui sont fréquemment utilisées en physique théorique ou en mathématiques. Savoir si le but sera atteint est une autre histoire… Enfin, et au risque de faire hurler certains mathématiciens, il nous semble plus important, tout au moins dans un premier temps, de se familiariser avec les idées fondamentales ainsi qu’avec de nombreux exemples, que de connaître le détail de toutes les démonstrations relatives aux propositions et théorèmes cités.

Le style adopté dans ce livre étant volontairement informel, il peut être parfois difficile au lecteur de retrouver la définition précise de tel ou tel concept. Pour cette raison, il peut être utile de consulter l’index situé en fin d’ouvrage, et, bien entendu, la table des matières.

Notre présentation est bien, sur, incomplète. Certains aspects ne sont qu’effleurés, d’autres sont totalement absents et bien qu’il ne s’agisse pas ici, loin s’en faut, d’une tentative encyclopédique, voici quelques têtes de chapitres dont on pourra déplorer l’absence… : compléments de géométrie différentielle élémentaire en basse dimension (la liste serait longue), géométrie symplectique et mécanique, opérateurs différentiels, pseudo-différentiels, symboles etc., étude des équations de Yang-Mills, instantons etc., classification des espaces fibrés, fibrés universels et espaces classifiants, K-théorie, classes caractéristiques (et classes caractéristiques secondaires), géométries sur les groupes de Lie et les espaces homogènes, applications harmoniques, aspects conformes, métriques et connexions invariantes (symétries, isométries), variétés complexes, hypercomplexes etc., géométrie de l’espace des orbites des connexions, géométrie de l’espace des métriques, etc.

Par ailleurs, l’auteur aurait aimé insérer, à la fin de chaque chapitre, une section consacrée aux généralisations des idées rencontrées, lorsqu’on passe de la géométrie commutative à la géométrie non commutative, c’est à dire lorsqu’on passe du classique au quantique 1 . Il est sans doute dommage de devoir parler au conditionnel passé… mais il fallait bien mettre fin à la rédaction ! De fait, faisant suite à une première version de cet ouvrage, rendue disponible sur Internet, en format html, en mai 1997, la dernière section (section 6), consacrée à une présentation générale des mathématiques non commutatives et au calcul différentiel sur les algèbres non commutatives, a été rajoutée en mars 1998. Ce rajout répond donc, en partie, à la préoccupation mentionnée plus haut.

Bien entendu, toutes les remarques permettant d’améliorer ce document, voire de corriger certaines sections si besoin est, sont les bienvenues : envoyer un courrier à l’auteur ou un courriel à coque at cpt.univ-mrs.fr.

On aura compris que ce livre a été rédigé en français. Certes, il eut été préférable, pour rassembler un plus large lectorat, de rédiger directement l’ouvrage en anglais. L’usage de la langue anglaise, et en particulier la lecture de l’anglais, sont devenus obligatoires dans notre société, et il est certain que l’enseignement de cette langue a fait des progrès considérables en France ; il n’en demeure pas moins que la lecture de textes en anglais, même de textes scientifiques, pose toujours à nos étudiants ainsi qu’à certains de leurs aînés, des difficultés. Il en va d’ailleurs de même pour une vaste partie du monde francophone, où le français n’est parfois qu’une deuxième langue (l’anglais venant en troisiìeme position). Il n’est pas certain que le présent ouvrage devienne un livre de chevet ( !) mais pour faciliter sa lecture sans rajouter une difficulté linguistique, l’auteur a décidé de rédiger ce livre directement en français. Ces notes sont donc dédiées aux étudiants et aux chercheurs de la francophonie, et à tous les esprits curieux qui souhaitent acquérir un certain nombre de notions géométriques des mathématiques contemporaines avant de s’embarquer eux-mêmes dans l’aventure de la recherche, que ce soit en Physique ou en Mathématique, ou qui souhaitent tout simplement satisfaire leur curiosité intellectuelle. Une version anglaise serait la bienvenue mais l’auteur n’a pas eu, jusqu’à présent, le courage de s’atteler à cette tâche.

L’ensemble du document (sa dernière version) est accessible, via internet, en version html ou pdf sur http://www.cpt.univ-mrs.fr/~coque/.

On trouvera assez peu de références mentionnées dans cet ouvrage. Il existait évidemment la tentation de citer tous les livres traitant, de près ou de loin, de géométrie différentielle, d’espaces fibrés, de connexions, de géométrie riemannienne etc . Un tel effort bibliographique semble évidemment, dès le départ, voué à l’échec. Une autre solution eût été de ne citer que les ouvrages élémentaires. Malheureusement, les ouvrages en question ne recouvrent pas nécessairement tous les sujets qui sont abordés ici. Enfin, on rappelle que la première rédaction de ces notes, avant leur mise à disposition sur internet, date de 1996 ; plusieurs ouvrages d’enseignement sur des sujets voisins sont apparus depuis. L’attitude que nous avons choisi d’adopter est de ne citer que les livres et autres travaux pour lesquels l’auteur a conscience d’avoir subi une influence possible ou certaine. Les documents en question sont assez variés : certains sont des ouvrages de référence, d’autres sont des monographies spécialisées, d’autres encore, des articles de recherche. L’auteur n’a pas cherché à suivre tel ou tel traité et a essayé de rédiger ces notes de façon originale… certains pourront peut-être s’en plaindre ! Tout ceci explique la raison du petit nombre de références, que voici.

[1] A. Besse. Einstein manifolds. Springer-Verlag, 1966.

[2] A. Connes. Noncommutative differential geometry. Publ. Math. IHES 62, 1985.

[3] A. Connes. Noncommutative geometry. Academic Press, 1994.

[4] R. Coquereaux and A. Jadczyk. Fiber bundles, Kaluza-Klein theories and all that. World Scientific, 1988.

[5] C.W.Misner, K.S.Thorne, and J.A. Wheeler. Gravitation. Freeman, 1973.

[6] M. Dubois-Violette. Dérivations et calcul differérentiel non commutatif. C.R. Acad. Sci. Paris 307, Ser. I, 403-408, 1988.

[7] M. Dubois-Violette and P. Michor. A common generalization of the Frolicher-Nijenhuis bracket and the Schouten bracket. Preprint LPTHE-Orsay 94/05, ESI 70, 1994.

[8] D. Husemoller. Fiber bundles. Springer-Verlag, 1966.

[9] S. Kobayashi and K. Nomizu. Foundations of differential geometry, VolI/III. Interscience, 1963.

[10] R. Kerner, M. Dubois-Violette and J. Madore. Classical bosons in a non-commutative geometry. Class. Quant. Grav. 6, 1709, 1989.

[11] G. Esposito Farese, R. Coquereaux and G. Vaillant. Higgs fields as Yang mills fields and discrete symmetries. Nucl. Phys. B 353, 689-706, 1991.

[12] R. Haussling, R. Coquereaux and F. Scheck. Algebraic connections on parallel universes. Int J. Mod. Phys. A, vol. 10, PP 89-98, 1995.

[13] Spivak. Differential Geometry. Publish or Perish, 1979.

Une variété topologique est tout d’abord un espace topologique, mais on suppose, de surcroît, que chacun de ses points possède un voisinage homéomorphe à un ouvert de ℝn. On dit alors que cet espace est une variété topologique de dimension n.

Intuitivement, une variété topologique de dimension 2 est un espace qui, localement, c’est à dire si on ne regarde pas trop loin, ressemble à un petit morceau de feuille de papier qu’on aurait pu découper avec des ciseaux après en avoir tracé le pourtour au crayon (on peut d’ailleurs froisser le bout de papier en question). La structure globale de cet espace peut être évidemment assez différente puisque la variété elle-même est obtenue par recollement de tous ces petits morceaux de papier. Ainsi, un pneu de bicyclette, éventuellement dégonflé, plié et “froissé” fournit un exemple d’objet physique qu’on peut modéliser à l’aide d’une variété topologique de dimension 2 : un tore.

Les variétés dont il vient d’être question n’ont pas de bord (au sens intuitif du terme). En effet, si nous nous transformons en êtres plats, rampant sur la surface d’un ballon – ou d’un pneu – nous ne sommes jamais arrêtés par une quelconque barrière. Cela ne serait pas le cas si nous nous déplacions sur la surface d’un quartier d’orange ou d’un pneu crevé (nous nous arrêterions au bord du trou !). Sans se transformer en êtres plats, cela ne serait pas le cas non plus si nous nous déplacions à l’intérieur d’une boule fermée. De façon générale, il est possible de fabriquer des “variétés à bord” en effectuant un ou plusieurs trous dans une variété sans bord (à l’aide d’une petite cuillère multi-dimensionelle !) ; la partie enlevée, comme la partie qui reste, devient une variété topologique à bord.

Pour préciser cette notion, il nous faut élargir la définition de variété que nous avons donné plus haut puisque certains des points (ceux du bord) ont un voisinage non pas homéomorphe à un ouvert de ℝn mais à un voisinage de ℝ +n (le fermé de ℝn formé des points dont la dernière composante est positive ou nulle).

Attention : si nous nous promenons dans une boule ouverte, nous ne pourrons jamais atteindre aucun bord... par définition d’une boule ouverte ! Une boule ouverte est une variété sans bord de dimension 3 qui est d’ailleurs homéomorphe à ℝ3. Par contre, une boule fermée est une variété à bord de dimension 3, les points du bords sont ceux de la sphère (une variété de dimension 2) et ils possèdent – dans la boule fermée – des voisinages particuliers. Le disque ouvert (la boule de dimension 2) est aussi une variété sans bord et le disque fermé est une variété à bord (son bord est constitué d’un cercle qu’on peut appeler également “sphère de dimension 1”. Dans le même genre, un intervalle ouvert est une variété sans bord (la boule de dimension 1) et un intervalle fermé est une variété à bord (son bord est constitué de deux points dont la réunion constitue ce qu’on peut appeler la sphère de dimension 0. Les exemples qui précèdent sont généralisables en toutes dimensions.

Terminologie : Si on ne précise pas davantage, une variété topologique est censée être une variété sans bord.

La plupart des objets mathématiques auxquels nous avons tendance à penser de prime abord sont des exemples de variétés topologiques (avec ou sans bord), et, pour cette raison, il est bon de donner quelques exemples d’espaces topologiques qui ne sont pas des variétés. Considérez par exemple une croix (réunion de deux segments d’intersection réduite à un point) ; ce n’est pas une variété car le point situé à l’intersection des deux segments possède des voisinages en forme de croix, et une croix n’est jamais homéomorphe à un ouvert de ℝ = ℝ1. Le globe impérial est un objet qu’on pourrait penser à modéliser mathématiquement par une sphère (variété de dimension 2) sur laquelle on aurait collé une croix (réunion de deux segments) Cet espace n’est pas une variété pour deux raisons. La première vient du point d’intersection des deux branches de la croix (déjà vu) et la deuxième est analogue puisque le point ou on a collé la croix sur la sphère possède des voisinages qui ne sont homéomorphes ni à des ouverts de ℝ1 ni à des ouverts de ℝ2.

Ces derniers exemples ne sont pas des variétés mais sont néanmoins obtenus par recollement de variétés... (CW complexes) Ils ne possèdent pas une dimension déterminée mais ont néanmoins une structure assez simple. On peut cependant faire bien pire... Les exemples d’espaces topologiques qui ne sont pas des variétés abondent (prenez par exemple des espaces topologiques qui ne sont pas de Haussdorf, c’est à dire qui possèdent des points qu’on ne peut pas séparer à l’aide d’ouverts disjoints). Il ne faudrait pas croire que les espaces qui ne sont pas des variétés n’ont pas d’intérêt mathématique ou physique, bien au contraire. En fait, la géométrie non commutative (dont nous ne parlerons pratiquement pas dans cet ouvrage) s’est développée en grande partie pour forger des outils permettant de “calculer” dans de tels espaces, espaces qui sont en fait complètement décrits par des algèbres associatives mais généralement non commutatives… Par ailleurs, on sait que la description mathématique de la mécanique quantique repose sur l’utilisation des algèbres d’opérateurs, ce qui explique la raison pour laquelle les phénomènes physiques relevant de cette mécanique soient si peu intuitifs puisqu’il nous faut, dans ce cas, abandonner nos notions familières de géométrie “commutative”. C’est à l’étude de cette géométrie commutative qu’est consacrée le présent ouvrage. Attention à la terminologie (mise en garde destinée au lecteur trop savant) : l’expression classique des théories de jauge non abéliennes ainsi que l’étude des groupes de Lie (en général non commutatifs), relèvent de la géométrie commutative ! Le calcul différentiel – et la physique classique – se sont développés dans le cadre des variétés et c’est pourquoi nous commençons par là. La structure de variété topologique est d’ailleurs elle-même insuffisante pour pouvoir travailler dans de bonnes conditions : Il nous faudra pouvoir différentier les fonctions un nombre de fois suffisant. Pour ce faire il nous faudra supposer que les variétés (en anglais manifolds) considérées ne sont pas “froissées” : elles doivent être “lisses” (bien repassées !). Ce sont les variétés différentiables (en anglais smooth manifolds).

Intuitivement, on peut considérer une variété différentiable comme une variété

topologique (voir exemples supra) qui soit “lisse”, c’est à dire sans plis, sans coins

etc. Une variété différentiable M de dimension n est donc avant tout une variété

topologique. Nous définissons tout s’abord la notion de carte qui généralise la

notion usuelle de carte géographique. Une carte consiste en la donnée d’un ouvert

Ui de M ainsi que d’une application x :  ∈ Ui ⊂ M

∈ Ui ⊂ M (xμ(

(xμ( )) ∈ ℝn avec

μ ∈{1…n}. Il importe de bien établir une distinction entre le point

)) ∈ ℝn avec

μ ∈{1…n}. Il importe de bien établir une distinction entre le point  lui-même et ce qu’on appelle ses coordonnées xμ(

lui-même et ce qu’on appelle ses coordonnées xμ( ) dans la carte choisie. On

suppose, de plus, que l’application x est bijective et bi-continue de Ui sur son

image.

) dans la carte choisie. On

suppose, de plus, que l’application x est bijective et bi-continue de Ui sur son

image.

Mis à part le cas relativement trivial où M est homéomorphe à ℝn, il

nous faut plusieurs cartes pour recouvrir la variété M. On appellera atlas

(sous-entendu différentiable) la donnée d’un ensemble de cartes (Ui,x) qui

recouvrent M c’est à dire telles que ∪iUi = M et telles que les changements de

cartes ϕij soient des bijections différentiables, ainsi que leurs inverses. Précisons ce

dernier point. Supposons que  ∈ Ui ∩ Uj ⊂ M, on peut donc représenter

∈ Ui ∩ Uj ⊂ M, on peut donc représenter  par un point xμ(

par un point xμ( ) de ℝn dans la carte (U

i,x) ou par un autre point

yμ(

) de ℝn dans la carte (U

i,x) ou par un autre point

yμ( ) de ℝn dans la carte (U

j,y). On note ϕij le changement de cartes

(encore appelé transformation de coordonnées) ; c’est une application de

l’ouvert x(Ui) de ℝn dans l’ouvert y(U

j) de ℝn. On sait ce que signifie

“différentiable” pour une application de ℝn dans ℝn : les dérivées partielles, par

rapport à chacune des variables, doivent exister. On impose donc à ϕij

d’être une application différentiable. On lui impose également d’être

bijective (donc inversible) et on impose à son inverse ϕji = ϕij-1 d’être

également différentiable. Bien entendu, il faut préciser un peu plus ce qu’on

entend par différentiable : suivant qu’on impose aux applications ϕij

d’être une seule fois différentiable, r fois différentiables ou infiniment

différentiables, on parle d’atlas de classe C1, Cr ou C∞. Dans la suite de

l’ouvrage et sauf mention explicite du contraire, c’est de classe C∞ qu’il

s’agira. La première façon de définir une variété différentiable est de se

donner une variété topologique ainsi qu’un atlas différentiable. Du pont de

vue des notations, il n’est pas très commode de faire figurer l’indice i

qui se rapporte à la carte, sur le système de coordonnées x ; dans le

cas où on en considère deux (par exemple x et y) on écrira les formules

de changement de carte (l’application ϕij) sans introduire de nouvelle

notation en écrivant simplement yμ comme une fonction de xν, c’est à dire

yμ = yμ(xν).

) de ℝn dans la carte (U

j,y). On note ϕij le changement de cartes

(encore appelé transformation de coordonnées) ; c’est une application de

l’ouvert x(Ui) de ℝn dans l’ouvert y(U

j) de ℝn. On sait ce que signifie

“différentiable” pour une application de ℝn dans ℝn : les dérivées partielles, par

rapport à chacune des variables, doivent exister. On impose donc à ϕij

d’être une application différentiable. On lui impose également d’être

bijective (donc inversible) et on impose à son inverse ϕji = ϕij-1 d’être

également différentiable. Bien entendu, il faut préciser un peu plus ce qu’on

entend par différentiable : suivant qu’on impose aux applications ϕij

d’être une seule fois différentiable, r fois différentiables ou infiniment

différentiables, on parle d’atlas de classe C1, Cr ou C∞. Dans la suite de

l’ouvrage et sauf mention explicite du contraire, c’est de classe C∞ qu’il

s’agira. La première façon de définir une variété différentiable est de se

donner une variété topologique ainsi qu’un atlas différentiable. Du pont de

vue des notations, il n’est pas très commode de faire figurer l’indice i

qui se rapporte à la carte, sur le système de coordonnées x ; dans le

cas où on en considère deux (par exemple x et y) on écrira les formules

de changement de carte (l’application ϕij) sans introduire de nouvelle

notation en écrivant simplement yμ comme une fonction de xν, c’est à dire

yμ = yμ(xν).

En géographie ordinaire (celle du globe terrestre) il est bien connu qu’il nous faut au moins deux cartes pour décrire la Terre. Par contre, rien ne nous interdit d’en utiliser trois ou plus …. Si on réunit les cartes d’un atlas avec celles d’un atlas différent (concernant la même variété topologique), on peut s’attendre à fabriquer ainsi un atlas plus grand, un peu redondant, certes, mais néanmoins utile. Il faut cependant prendre la précaution d’imposer aux cartes d’être compatibles, c’est à dire telles que les formules de changements de cartes, d’un atlas à l’autre, puissent s’exprimer en terme de transformations différentiables de ℝn. Cette précaution n’est pas inutile et peut conduire à des surprises. Rien ne nous empêche alors de considérer l’ensemble (assez gros il est vrai !) de tous les atlas compatibles possibles d’une variété donnée et de les réunir en un unique atlas maximal. Bien qu’un seul atlas suffise à caractériser complètement la variété, il peut être très utile de considérer la variété M équipée d’un tel atlas maximal contenant toutes les cartes compatibles possibles. En d’autres termes, on peut complètement caractériser une variété différentiable par la donnée d’une variété topologique et d’un atlas maximal. Il se trouve que, dans certains cas, une variété topologique donnée possède plusieurs structures différentiables (plusieurs atlas maximaux distincts). C’est le cas pour ℝ4 (le seul, parmi les espaces numériques ℝn à posséder des structures différentiables “exotiques”) et c’est aussi le cas pour les sphères Sn lorsque n ≥ 7. Nous ne nous intéresserons pas à ces phénomènes dans le cadre de cet ouvrage.

En mathématiques élémentaires, on définit souvent les espaces géométriques intéressants (par exemple une sphère) comme sous espace d’un espace affine ℝn. L’idée fondamentale du calcul sur les variétés (calcul différentiel intrinsèque comme on l’appelait autrefois) est de faire abstraction du fait que la variété qui nous intéresse est, ou non, plongée dans un espace ℝn “plus grand” et de développer un calcul qui soit totalement indépendant du plongement en question. Les motivations physiques sont analogues. Par exemple, l’expérience quotidienne nous montre que tout événement de l’univers sensible (whatever it means) peut se décrire à l’aide de quatre nombres spécifiant sa position (trois nombres) et sa date (un nombre). Mais pourquoi supposer, a priori que l’ensemble de ces événements doive être décrit à l’aide d’un un espace ℝ4 ? Pourquoi pas une hyper-sphère (ou n’importe quoi d’autre ?) Mais alors, si on décide d’utiliser une hyper-sphère de dimension 4 pour décrire notre espace-temps, ou, comme dans certains modèles cosmologiques, comme le produit d’une hyper-sphère (gonflable) de dimension 3 par une droite ou une demi-droite, pourquoi supposer que notre variété est plongée dans un espace de dimension 5 ou plus dont les points sont sans signification physique ? Puisque c’est possible, autant travailler dans la variété qui nous intéresse sans chercher à en “sortir”.

L’idée la plus fondamentale et la plus simple du calcul différentiel sur les variétés est la suivante. Grâce à l’existence locale des cartes, on peut toujours faire “comme si” on était sur ℝn et développer des outils et des méthodes de calcul sans se soucier – dans un premier temps – de leur globalisation, quitte à vérifier, par la suite, que tout se recolle comme il faut lorsqu’on passe d’une carte à l’autre. C’est ainsi que l’essentiel des notions qui suivent sont en fait des notions qui peuvent être définies dans un espace ℝn et dont la généralisation, au cas des variétés, est quasi-immédiate. Nous ne supposons pas que le lecteur est déjà familier des notions en question ; c’est la raison d’être des paragraphes qui suivent.

Soient M et N deux variétés différentiables de dimensions respectives m et n. Une application différentiable ϕ de M dans N est une application qui peut s’écrire localement à l’aide d’une application différentiable (encore notée ϕ) de ℝm dans ℝn. En d’autres termes, si on a Q ∈ N = ϕ(P) avec P ∈ M, alors, grâce au choix de cartes P ∈ Ui ⊂ M → xμ(P) ∈ ℝm et Q ∈ V i ⊂ N → yν(Q) ∈ ℝn, on pourra écrire (et on écrira !) y = ϕ(x) ce qui signifie, en fait yν(Q) = ϕ(xμ(P)). L’ensemble des applications différentiables de M dans N se note C∞(M,N).

Petite parenthèse sur le problème des notations en mathématiques : Il est important de comprendre la signification de ce qu’on écrit, mais il est (de l’avis de l’auteur) absurde de vouloir que la notation utilisée nous rappelle à tout moment les différents abus d’écriture commis depuis le chapitre 1 du tome 1 de Bourbaki et sans lesquels il n’est pas de calcul possible !

L’application ϕ (celle qui va de M dans N) est donc caractérisée – les cartes étant choisies – par n fonctions différentiables yν de m variables xμ. Il est alors naturel de considérer la matrice jacobienne de cette application, c’est à dire la matrice rectangulaire m × n des dérivées partielles ∂yν ∂xμ. Nous en reparlerons un peu plus tard.

Il existe deux cas particuliers particulièrement intéressants.

Le premier est celui où M et N coïncident. Dans ce cas, il peut se faire que l’application différentiable ϕ soit non seulement différentiable mais encore bijective et que son inverse soit également différentiable. On dit alors que ϕ est un difféomorphisme. Notons qu’une application différentiable est automatiquement continue et que, par conséquent, un difféomorphisme est automatiquement un homéomorphisme. Il est facile de vérifier que l’ensemble des difféomorphismes d’une variété différentiable M constitue un groupe pour la composition des applications. On note ce groupe Diff(M) ⊂ C∞(M,M) ; c’est un sous groupe de l’ensemble Hom(M) ⊂ C0(M,M) des homéomorphismes de M. Notons qu’il existe une correspondance assez subtile entre difféomorphismes d’une part – qui sont des transformations que l’on appelait autrefois “actives” car elles transforment les points de M en d’autres points de M – et changements de coordonnées – qui sont des transformations que l’on appelait autrefois “passives” car elles ne transforment pas les points de M mais résultent seulement d’un changement de carte.

Il est à peu près évident que ces deux notions coïncident dans le cas où M est l’espace ℝn lui-même (muni de la structure différentiable définie par une unique carte canonique, l’application identique). Examinons de plus près le cas général. Les cartes étant elles-mêmes des difféomorphismes locaux entre ouverts de M et ouverts de ℝn, effectuer un changement de carte (changement de système de coordonnées) se traduit par un difféomorphisme local y(x) de ℝn. Par contre, un difféomorphisme de M est, par définition, une notion globale qui se traduit elle-aussi, après choix de cartes, par un difféomorphisme local de ℝn. L’équivalence des points de vue “actifs” et “passifs” n’existe donc que pour ℝn et il semble préférable d’éviter cette terminologie. Une idée physique fondamentale, à la base de la théorie de la relativité générale est que les équations de la physique doivent pouvoir s’écrire de façon tout à fait indépendante de l’observateur, quelle que soit l’état de mouvement de ce dernier. Traduite en termes de coordonnées, ce “Principe de Relativité Générale” a souvent été exprimé de par le passé comme affirmant l’indépendance des lois de la physique par rapport aux changements de systèmes de coordonnées. Une telle affirmation manque de précision, dès lors qu’on travaille sur une variété quelconque et non sur un espace numérique. Il semble d’ailleurs qu’A. Einstein lui-même n’ait jamais pu exprimer correctement ce principe de façon vraiment précise et moderne (cela n’enlève rien à son génie !). Le principe en question peut s’énoncer ainsi : l’espace-temps étant décrit par une variété différentiable, les lois de la physique doivent être invariantes sous l’action du groupe des difféomorphismes de cette variété.

La deuxième classe de cas particuliers intéressants est celle où l’application différentiable considérée ϕ, de M dans N est définie sur une variété quelconque M, mais ou N coïncide avec l’ensemble ℝ des nombres réels. Les applications différentiables en question sont désignées sous le nom de fonctions différentiables sur M ; l’utilisation du mot “fonction” est en accord avec les habitudes terminologiques anglaises, où les applications quelconques sont des “maps” , mais où les applications à valeurs réelles (ou complexes) sont des “functions”. L’ensemble des fonctions différentiables sur M se note C∞(M) = C∞(M, ℝ).

Remarque : l’ensemble des fonctions différentiables C∞(M) est une algèbre pour l’addition des fonctions [f + g](x) = f(x) + g(x), la multiplication des fonctions définie (ponctuellement) par [fg](x) = f(x)g(x) et l’opération externe de multiplication par un nombre réel. C’est une sous-algèbre de l’algèbre commutative C0(M).

Le lecteur peut s’étonner de la présence et de la signification de l’indice supérieur 0 ou ∞ dans les notations C0(M) ou C∞(M). Cet indice se réfère à l’ordre de différentiabilité supposé des fonctions appartenant à l’ensemble considéré. On pourrait bien entendu considérer des ensembles tels que Cp(M) constitués de fonctions qui sont, au moins, p fois différentiables. Dans la suite de cet ouvrage, cependant, nous nous limiterons aux cas p = 0, c’est à dire les fonctions continues (qui peuvent évidemment être différentiables ou non) et p = ∞, c’est à dire les fonctions infiniment différentiables.

Avant de donner une définition générale des vecteurs et champs de vecteurs,

définition qui pourrait sembler assez abstraite de prime abord, nous souhaitons

motiver quelque peu cette définition. Le lecteur est déjà supposé être familier de

la notion élémentaire de vecteur, à savoir une classe d’équivalence de

bi-points parallèles et de même sens, dans l’espace affine ℝn. Un champ de

vecteurs de ℝn, au sens élémentaire du terme, est donc une application

qui, à tout point de ℝn – considéré comme espace affine – associe un

vecteur de ℝn –considéré comme espace vectoriel. Intuitivement, on a

une “flèche” en tout point ; on peut penser à l’exemple du champ des

vitesses d’un solide en mouvement, mais on peut aussi penser au champ

magnétique en tout point de l’espace, etc. En physique – mais aussi, comme

nous allons le voir, en mathématiques – un vecteur peut être considéré

comme un “petit déplacement”. Soit M une variété différentiable, f

une fonction différentiable ainsi que P et Q deux points de M. Si M

était un espace affine (comme ℝn), cela aurait un sens de considérer la

différence de Q et de P, puisque cette différence définirait simplement le

vecteur  = Q - P. On pourrait aussi (mais on peut de toutes façons)

considérer la différence f(Q) - f(P) des valeurs prises par f en Q et

P. Dans le cas de M = ℝn et lorsque Q (coordonnées x′) tend vers P

(coordonnées x), le théorème des accroissement finis (ou celui de Taylor) nous dit

que 1

f(x′) - f(x) = (x′- x)i∂∕∂xif(x) + … = vi∂∕∂xif(x) + … où les nombres

vi = (x′-x)i ne sont autres que les composantes du vecteur

= Q - P. On pourrait aussi (mais on peut de toutes façons)

considérer la différence f(Q) - f(P) des valeurs prises par f en Q et

P. Dans le cas de M = ℝn et lorsque Q (coordonnées x′) tend vers P

(coordonnées x), le théorème des accroissement finis (ou celui de Taylor) nous dit

que 1

f(x′) - f(x) = (x′- x)i∂∕∂xif(x) + … = vi∂∕∂xif(x) + … où les nombres

vi = (x′-x)i ne sont autres que les composantes du vecteur  = Q-P dans le

repère où P et Q ont des composantes xi et x′i. Dans le cas des variétés,

l’expression (x′- x)i∂∕∂xif(x) a encore un sens. En effet, choisissons tout

d’abord une carte, et notons v la quantité v = vi∂∕∂xi. Si x(P) sont les

coordonnées de P dans le domaine de la carte x, on pourra considérer la

quantité

= Q-P dans le

repère où P et Q ont des composantes xi et x′i. Dans le cas des variétés,

l’expression (x′- x)i∂∕∂xif(x) a encore un sens. En effet, choisissons tout

d’abord une carte, et notons v la quantité v = vi∂∕∂xi. Si x(P) sont les

coordonnées de P dans le domaine de la carte x, on pourra considérer la

quantité

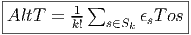

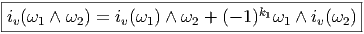

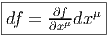

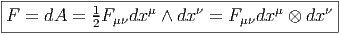

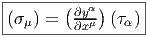

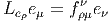

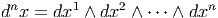

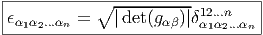

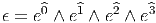

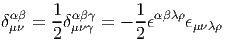

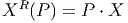

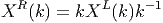

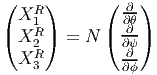

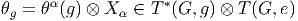

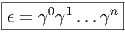

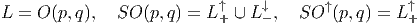

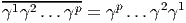

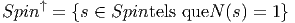

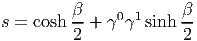

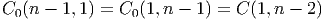

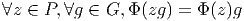

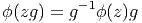

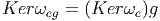

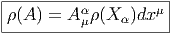

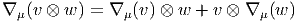

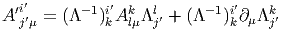

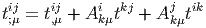

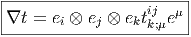

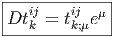

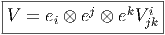

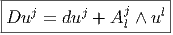

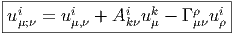

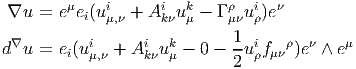

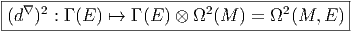

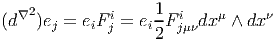

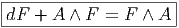

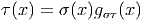

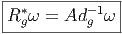

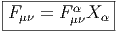

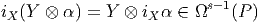

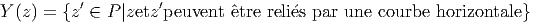

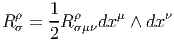

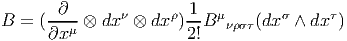

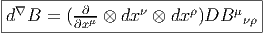

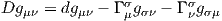

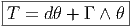

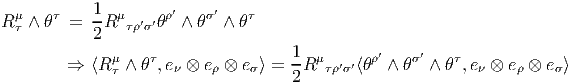

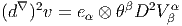

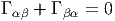

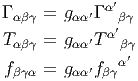

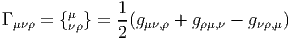

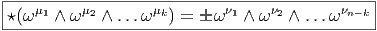

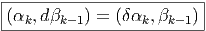

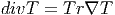

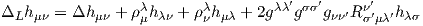

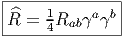

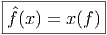

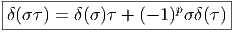

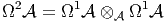

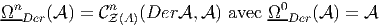

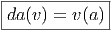

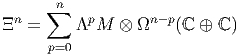

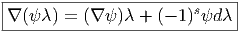

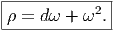

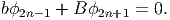

![|-----------------|

|v[f] = vi-∂if(x) |

----------∂x------](source4x.png)

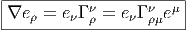

Dans le cas des variétés, il est clair que les vecteurs ne peuvent pas être définis comme des bi-points (ou des classes d’équivalences de bi-points), par contre, rien ne nous empêche d’utiliser leur propriété de machine-à-fabriquer-des-dérivées-partielles pour les définir de façon générale. Dans le domaine d’une carte x, un champ de vecteurs sera donc défini comme un opérateur de différentiation d’ordre 1 à savoir

L’opérateur différentiel d’ordre 1 noté v = vi∂∕∂xi est un champ de vecteurs car les vi sont des fonctions sur M alors que v(P) = vi(P)∂∕∂xi est un vecteur au point P, de composantes vi(P).

En géométrie élémentaire des courbes, la tangente en P à une courbe

(différentiable) est définie comme limite des sécantes PQ lorsque Q tends vers

P ; cela signifie que les vecteurs  tendent vers un vecteur tangent à la courbe.

En géométrie des variétés différentiables, on pourrait faire de même, à

condition de plonger notre variété (par exemple la sphère usuelle S2) dans

un espace plus grand (par exemple ℝ3) et voir ainsi, un vecteur de S2

comme un vecteur tangent à la sphère (et donc “sortant” de celle-ci) ; mais

une telle contrainte serait précisément contraire à l’idée même du calcul

intrinsèque sur les variétés, calcul qui se veut, justement, indépendant de

l’existence de plongements possibles. La définition adoptée précédemment est

bien indépendante de la présence d’un espace affine ambiant, mais il est

néanmoins commode, pour l’intuition, de visualiser nos vecteurs de façon

élémentaire et d’adopter une terminologie qui nous rappelle des situations bien

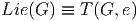

connues. Pour ces raisons, un vecteur de la variété M en un point P est

souvent appelé vecteur tangent en P, l’ensemble de ces vecteurs se note

T(M,P) ou encore TP M et est désigné sous le nom de espace tangent à

M en P ; on a donc un espace tangent en chaque point de la variété.

L’ensemble des vecteurs eux-mêmes (tous les vecteurs), se note T(M) ou

simplement TM et est appelé l’espace tangent à M ou encore, pour une

raison qu’on expliquera ultérieurement le fibré tangent à M (“tangent

bundle”). Un élément de TM est donc la donnée (P,u) d’un point de M et

d’un vecteur en ce point. Attention, il faut bien distinguer les notions

de vecteur en un point et de champs de vecteurs (mais nous allons très

souvent oublier cette distinction). L’ensemble des champs de vecteurs se

note ΓTM. Notons que cet espace est un espace vectoriel (de dimension

infinie), et T(M,P) est un espace vectoriel de dimension n (supposant que

M est elle-même de dimension n), alors que TM n’est pas un espace

vectoriel du tout (on ne peut pas additionner un vecteur en P avec un

vecteur en Q !). On verra que TM, que l’on peut considérer comme une

collection d’espaces vectoriels paramètrisés par les points de M, possède la

structure d’espace fibré vectoriel (cette structure sera définie et étudiée plus

loin). Notons que l’espace TM est lui-même une variété différentiable.

Supposons que M soit une variété de dimension n, un point P de M est en

effet caractérisé (dans une certaine carte) par n composantes xμ et un

“point” (c’est à dire un élément) de TM consistera en la donnée d’un

couple (P,u) ∈ M × T(M,P) c’est à dire 2n nombres (n nombres xμ et n

composantes du vecteur u dans une base choisie de l’espace vectoriel T(M,P).

Ainsi TM est une variété de dimension 2n. Intuitivement, on peut se

représenter par exemple TS2 comme la donnée d’une infinité de plans

tangents collés à la sphère ; il s’agit, dans ce cas d’une variété de dimension

4.

tendent vers un vecteur tangent à la courbe.

En géométrie des variétés différentiables, on pourrait faire de même, à

condition de plonger notre variété (par exemple la sphère usuelle S2) dans

un espace plus grand (par exemple ℝ3) et voir ainsi, un vecteur de S2

comme un vecteur tangent à la sphère (et donc “sortant” de celle-ci) ; mais

une telle contrainte serait précisément contraire à l’idée même du calcul

intrinsèque sur les variétés, calcul qui se veut, justement, indépendant de

l’existence de plongements possibles. La définition adoptée précédemment est

bien indépendante de la présence d’un espace affine ambiant, mais il est

néanmoins commode, pour l’intuition, de visualiser nos vecteurs de façon

élémentaire et d’adopter une terminologie qui nous rappelle des situations bien

connues. Pour ces raisons, un vecteur de la variété M en un point P est

souvent appelé vecteur tangent en P, l’ensemble de ces vecteurs se note

T(M,P) ou encore TP M et est désigné sous le nom de espace tangent à

M en P ; on a donc un espace tangent en chaque point de la variété.

L’ensemble des vecteurs eux-mêmes (tous les vecteurs), se note T(M) ou

simplement TM et est appelé l’espace tangent à M ou encore, pour une

raison qu’on expliquera ultérieurement le fibré tangent à M (“tangent

bundle”). Un élément de TM est donc la donnée (P,u) d’un point de M et

d’un vecteur en ce point. Attention, il faut bien distinguer les notions

de vecteur en un point et de champs de vecteurs (mais nous allons très

souvent oublier cette distinction). L’ensemble des champs de vecteurs se

note ΓTM. Notons que cet espace est un espace vectoriel (de dimension

infinie), et T(M,P) est un espace vectoriel de dimension n (supposant que

M est elle-même de dimension n), alors que TM n’est pas un espace

vectoriel du tout (on ne peut pas additionner un vecteur en P avec un

vecteur en Q !). On verra que TM, que l’on peut considérer comme une

collection d’espaces vectoriels paramètrisés par les points de M, possède la

structure d’espace fibré vectoriel (cette structure sera définie et étudiée plus

loin). Notons que l’espace TM est lui-même une variété différentiable.

Supposons que M soit une variété de dimension n, un point P de M est en

effet caractérisé (dans une certaine carte) par n composantes xμ et un

“point” (c’est à dire un élément) de TM consistera en la donnée d’un

couple (P,u) ∈ M × T(M,P) c’est à dire 2n nombres (n nombres xμ et n

composantes du vecteur u dans une base choisie de l’espace vectoriel T(M,P).

Ainsi TM est une variété de dimension 2n. Intuitivement, on peut se

représenter par exemple TS2 comme la donnée d’une infinité de plans

tangents collés à la sphère ; il s’agit, dans ce cas d’une variété de dimension

4.

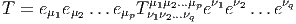

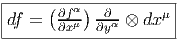

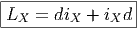

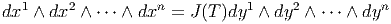

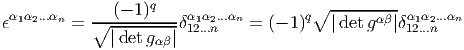

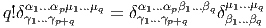

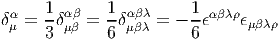

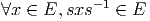

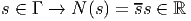

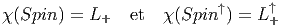

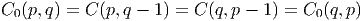

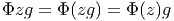

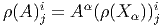

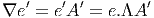

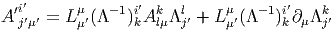

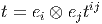

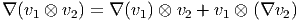

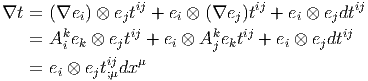

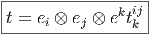

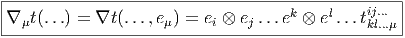

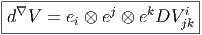

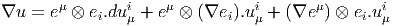

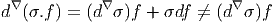

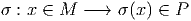

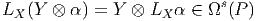

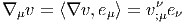

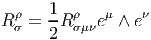

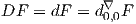

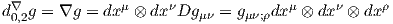

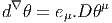

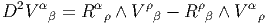

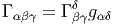

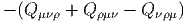

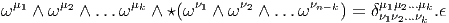

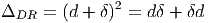

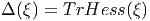

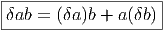

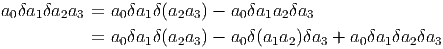

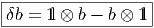

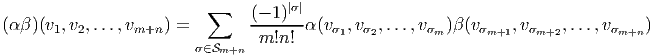

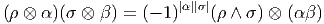

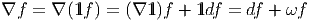

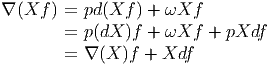

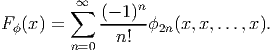

Soit v un champ de vecteurs. Il pourra donc s’écrire localement (c’est à dire dans une certaine carte) v = vμ∂∕∂xμ. Si f et g désignent deux fonctions sur M, il est clair que

![-∂-[fg ] =--∂-[f]g + f--∂-[g]

∂xμ ∂x μ ∂x μ](source7x.png)

![|---------------------|

-v[fg] =-v[f-]g-+-f-v[g-]|](source8x.png)

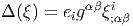

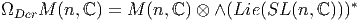

est une algèbre associative, on dit que v est une dérivation, lorsque

v est une application linéaire (un “opérateur”) de A dans A telle que

v[fg] = v[f]g + fv[g] avec f,g ∈

est une algèbre associative, on dit que v est une dérivation, lorsque

v est une application linéaire (un “opérateur”) de A dans A telle que

v[fg] = v[f]g + fv[g] avec f,g ∈ . Les champs de vecteurs sont des

dérivations de l’algèbre associative (et commutative) C∞(M). On pourrait

d’ailleurs les définir directement par cette propriété. En d’autres termes,

ΓTM = DerC∞(M).

. Les champs de vecteurs sont des

dérivations de l’algèbre associative (et commutative) C∞(M). On pourrait

d’ailleurs les définir directement par cette propriété. En d’autres termes,

ΓTM = DerC∞(M).

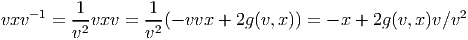

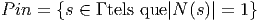

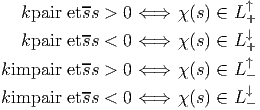

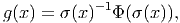

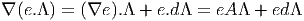

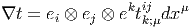

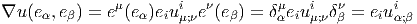

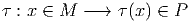

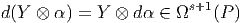

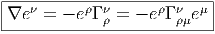

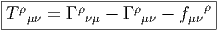

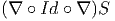

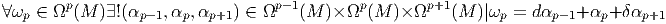

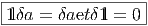

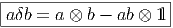

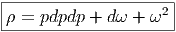

Notons que le produit de deux vecteurs n’est pas un vecteur (produit défini par composition de l’action des vecteurs sur les fonctions) mais un opérateur différentiel d’ordre 2. En effet, soient v = vμ∂∕∂xμ et w = wν∂∕∂xν deux champs de vecteurs (attention les vμ est les wν n’ont aucune raison d’être constants dans la carte choisie). Alors, (vw)[f] = v[w[f]] = v[wν∂∕∂xν[f]] = vμ∂∕∂xμ[wν∂∕∂xν[f]] = vμ∂∕∂xμ[wν]∂∕∂xν[f]+vμwν∂2∕∂xμ∂xν[f] Par contre, le commutateur (notation crochet) de deux champs de vecteurs, défini par

![|-----------------|

-[v,-w] =-vw---wv--|](source9x.png)

![μ ∂ ν ∂ μ ∂ ν ∂

[v, w][f ] = (vw )[f] - (wv )[f] = (v--μ-[w ]--ν-- w ---μ[v ]---ν)[f ]

∂x ∂x ∂x ∂x](source10x.png)

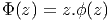

Antisymétrie

![|---------------|

|[u,v] = - [v,u]|

----------------](source11x.png)

![|-----------------------------------|

[u,[v,w-]] +-[v,[w,-u]] +-[w,[u,v]] =-0](source12x.png)

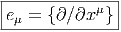

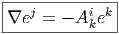

On appelle repère sur U ⊂ M, la donnée, en chaque point P ∈ U, d’une base de l’espace vectoriel tangent en P. Un repère est en général “local”, c’est à dire qu’on n’essaye pas, ou qu’on ne peut pas choisir U = M. Si xμ(P) désignent les composantes de P dans une carte locale (U,x), on a déjà vu que des vecteurs quelconques en P ou dans un voisinage de P peuvent se décomposer sur les vecteurs ∂∕∂xμ. En d’autres termes, l’ensemble des

![[eμ,e ν] = 0](source14x.png)

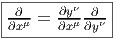

Soit P ∈ M → y(P) ∈ ℝn un nouveau système de coordonnées. Si x désigne

l’ancien système, on notera également y : ℝn ℝn les fonctions de changement de

carte, on écrira donc y(P) = y(x(P)). Le repère naturel associé aux coordonnées

x est eμ = {∂∕∂xμ}, celui associé aux coordonnées y est e

μ′ = {∂∕∂yμ}. Nous

savons (depuis le secondaire) comment calculer la dérivée d’une fonction

composée, et donc

ℝn les fonctions de changement de

carte, on écrira donc y(P) = y(x(P)). Le repère naturel associé aux coordonnées

x est eμ = {∂∕∂xμ}, celui associé aux coordonnées y est e

μ′ = {∂∕∂yμ}. Nous

savons (depuis le secondaire) comment calculer la dérivée d’une fonction

composée, et donc

Il est souvent commode de noter tout simplement ∂μ les vecteurs du repère naturel {eμ = ∂∕∂xμ} associés à la carte xμ. La décomposition d’un vecteur quelconque v suivant ce repère s’écrit v = vμ∂ μ, où les vμ sont des nombres réels.

Dans un espace vectoriel, nous savons que les changements de base sont décrits par des matrices “de passage” qui ne sont autres que des matrices inversibles Λαμ quelconques. En géométrie différentielle, nous pouvons bien entendu faire de même, à ceci près que la matrice Λαμ peut maintenant dépendre du point de la variété. En d’autres termes, on a des matrices de passage dont les éléments sont des fonctions sur la variété. Supposons que nous nous trouvons dans le domaine d’une carte et que {∂μ} désigne le repère naturel associé. Ce repère, au point P, constitue une base de l’espace tangent en P. Mais rien ne nous empêche de choisir une autre base au même point. Si Λαμ désigne une matrice inversible en P, alors la famille de vecteurs {eα = Λαμ∂ μ} est une autre base de l’espace tangent TpM, c’est à dire un repère au point P. Un tel repère est couramment désigné sous le nom de repère mobile. Notons qu’il n’y a aucune raison, a priori, pour que ce repère coïncide avec le repère naturellement associé à une autre carte que celle des xμ ; pour que cela soit le cas, il faudrait qu’on puisse trouver une solution locale yα au système d’équations ∂yα∕∂xμ = (Λ-1) μα) où Λ-1 désigne la matrice inverse de la matrice Λ. Le théorème garantissant l’existence de solutions pour une équation différentielle aux dérivées partielles nous assure seulement l’existence d’une telle solution yμ(xν)) le long d’une ligne, mais pas dans un voisinage ouvert de la variété.

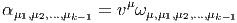

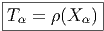

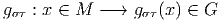

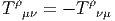

Soit {eα} un repère mobile. Nous avons déjà vu que le crochet (commutateur) de deux champs de vecteurs est un champ de vecteurs. En particulier [eα,eβ] est un champ de vecteurs qui, évalué au point P, appartient à l’espace tangent en ce point et peut donc se décomposer sur une base de l’espace tangent en P. On écrira donc

= f αβ(P )eγ(P )](source18x.png)

![|---------------|

|[eα,eβ ] = fγ eγ|

-----------αβ----](source19x.png)

Par ailleurs, on posera souvent ∂α = eα même s’il n’existe pas de système de coordonnées {yα} tel que ∂ α soit le repère naturel associé. Le lecteur doit donc se méfier de cet abus d’écriture pourtant commode : il est des cas où ∂α et ∂β ne commutent pas !

Avant de passer au cas des variétés, il convient d’effectuer quelques rappels d’algèbre linéaire puisque le passage du cas vectoriel au cas des variétés s’effectue essentiellement en remplaçant un espace vectoriel unique par une famille d’espaces vectoriels “de même nature”, paramètrisée par les points de la variété.

Soit E un espace vectoriel de dimension finie n sur un corps K. On note E* son dual, c’est à dire l’ensemble des formes K-linéaires sur E (applications linéaires sur E à valeurs dans le corps de base, qu’on suppose commutatif). En terme de composantes, soit {eμ} une base de E, et {eμ} la base duale correspondante de E*, on a

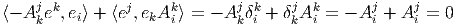

![eμ[e ν] = δμν](source20x.png)

L’espace vectoriel E de référence étant choisi, on écrira (comme le font toujours les physiciens) les vecteurs de base avec des “indices en bas” et les composantes avec des “indices en haut”. Bien entendu, la convention est opposée pour ce qui concerne l’espace vectoriel dual. Par ailleurs nous adoptons également la “convention d’Einstein”, c’est à dire que nous effectuons toujours une sommation (le signe somme étant sous-entendu) sur les indices répétés, lorsque l’un des indices est en position haute et l’autre en position basse. Nous avons déjà utilisé cette convention dans les sous-sections précédentes. Cette convention allège considérablement l’écriture des formules.

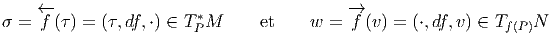

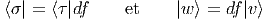

Nous n’adopterons pas, dans cet ouvrage, la notation dyadique chère à Dirac utilisant des bra et des ket car elle est peu usuelle en géométrie mais il est peut-être utile d’y consacrer quelques lignes. Avec cette notation, les éléments d’un certain espace vectoriel E choisi une fois pour toutes sont notés avec des “kets”, par exemple |v⟩ et les éléments du dual avec des “bras”, par exemple ⟨σ|. L’évaluation d’une forme sur un vecteur se note ainsi naturellement sous forme de “bracket” ⟨σ|v⟩. La relation précédente caractérisant la dualité entre une base de E et une base de E* s’écrira donc

Par contre, la quantité |eν⟩⟨eμ| désigne une application linéaire de E dans E puisque |eν⟩⟨eμ|e ρ⟩ = |eν⟩δρμ = |e ρ⟩. Ainsi, en prenant |v⟩ = vρ|e ρ⟩, on obtient |eν⟩⟨eμ|v⟩ = vμ|e ν⟩. Pour les mêmes raisons, l’écriture |v⟩⟨σ| désigne un opérateur (alors que ⟨σ|v⟩ désigne un nombre).

L’identification des vecteurs de E avec des applications de K dans E (à v ∈ E on associe l’application λ ∈ K → λv ∈ E) permet de bien comprendre cette dualité et l’intérêt de la notation dyadique.

Si on se souvient “qui est qui”, et si on fait attention à l’ordre des termes, on peut simplifier les notations à l’extrême et ne noter ni les produits tensoriels, ni les symboles ⟨| ou |⟩. On écrira ainsi parfois de façon un peu provocante les éléments de E sous la forme

L’ordre adopté ci-dessus (le fait d’écrire les composantes —qui sont pourtant des nombres !— à droite des vecteurs, etc) est particulièrement adapté aux généralisations non commutatives de la géométrie différentielle – cela vient du fait qu’en Occident, nous écrivons de gauche à droite !– mais rappelons nous que, bien entendu, en géométrie ordinaire “commutative” (celle qui nous intéresse ici), on peut toujours écrire v = eμvμ = vμe μ. Un dernier mot de mise en garde : lorsqu’on veut insister sur le fait que le vecteur eμ désigne une dérivation ∂μ, il est préférable – pour ne pas se tromper ! – d’écrire les composantes du côté gauche. Il en va de même en géométrie non commutative où champs de vecteurs et dérivations d’algèbre sont de toute façon des concepts différents puisque les premiers forment un module sur l’algèbre associative des “fonctions” alors que les dérivations ne forment un module que sur le centre de cette algèbre. Aucune ambiguïté n’est donc possible dans ce cadre plus général.

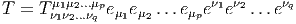

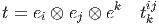

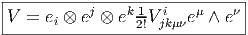

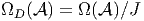

On note ⊗ E l’algèbre tensorielle sur E c’est à dire la somme directe ⊕p=0∞E⊗p où E⊗p désigne la puissance tensorielle d’ordre p de E, c’est à dire encore l’ensemble des applications multilinéaires d’ordre p sur E*. Soit T ∈ E⊗p alors on peut écrire

Bien entendu, nous pourrons considérer des tenseurs p-fois contravariants et q-fois covariants (éléments T de E⊗p ⊗ E*⊗q) et pour rester cohérents avec nos notations, nous écrirons les produits tensoriels des vecteurs de E à gauche de ceux de E*, c’est à dire

On notera Λk(E*) l’espace vectoriel des formes k-linéaires alternées sur E. Rappelons que T ∈ E*⊗k est alternée lorsque T(v 1,…,vi…,vj,…,vk) = 0 dès que vi = vj,i≠j. Il est équivalent de dire (si le corps de base n’est pas de caractéristique 2) que T est antisymétrique, c’est à dire que T(v1,…,vi…,vj,…,vk) = -T(v1,…,vj…,vi,…,vk). On dit aussi que T est une forme extérieure d’ordre k et que Λ(E*) est l’algèbre extérieure construite sur E*.

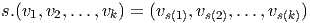

Le groupe symétrique  k des substitutions sur k éléments opère de

façon évidente sur les k-uplets de vecteurs. Soit s ∈

k des substitutions sur k éléments opère de

façon évidente sur les k-uplets de vecteurs. Soit s ∈ k

k

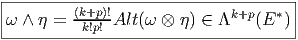

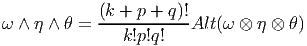

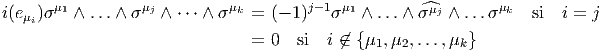

Soient ω ∈ Λk(E*) et η ∈ Λp(E*). On définit Le produit extérieur ∧,

Propriétés :

∧ est associatif et distributif à droite et à gauche sur +

aω ∧ η = ω ∧ aη = a(ω ∧ η) avec a ∈ ℝ

ω ∧ η = (-1)(pk)η ∧ ω En particulier, si ω est impaire, ω ∧ ω = 0

Ces propriétés font de Λ(E*) = ⊕ k=0nΛk(E*) une algèbre super-commutative (une algèbre commutative ℤ2-graduée).

De plus, si ω ∈ Λk(E*), η ∈ Λp(E*) et θ ∈ Λq(E*), alors

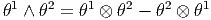

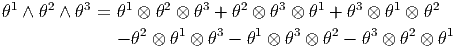

La présence des diverses factorielles dans les expressions ci-dessus, aussi bien dans la définition de Alt que dans celle du produit extérieur, disparaît dans bien des cas ; par exemple, le lecteur pourra se convaincre que si {θμ} désigne une base de 1-formes, les définitions précédentes conduisent aux expressions suivantes :

Il faut signaler ici qu’il existe une autre définition du produit extérieur où les membres de droite des expressions précédentes sont respectivement multipliés par 1∕2! et 1∕3! La définition adoptée ici est telle que si {eμ} désigne une base de l’espace vectoriel considéré et {θμ} la base duale correspondante, nous avons

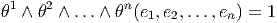

Désignons par {θμ} μ∈{1,2…n} une base de E*. Considérons un monôme tel que θμ1 ∧ θμ2 ∧… ∧ θμk. Par suite de l’antisymétrie du produit extérieur, il est clair qu’une telle expression est nulle dès qu’un vecteur de base est répété deux fois (c’est une autre façon de dire qu’un tenseur complètement antisymétrique est nul dès que deux indices sont répétés). Par ailleurs, deux monômes de ce type qui ne diffèrent que par l’ordre des termes sont soit égaux, soit opposés. On peut donc supposer que les indices sont ordonnés de la façon suivante : 1 ≤ μ1 < μ2 < … < μk ≤ n. Enfin, il est facile de voir que toute forme extérieure d’ordre k, c’est à dire tout élément de Λk(E*) peut se décomposer sur des monômes de ce type. La dimension de l’espace vectoriel Λk(E*) est donc ( kn). Bien entendu, lorsque k > n, toute forme extérieure est nulle (deux indices sont alors automatiquement répétés !). La dimension de l’algèbre extérieure est donc Σk=0n kn = 2n. Pour conclure ce paragraphe, citons sans démonstration (mais elle est facile) le petit résultat bien utile suivant : Les formes linéaires ω1,ω2,…,ωp sont indépendantes si et seulement si leur produit extérieur ω1 ∧ ω2 ∧… ∧ ωp est non nul.

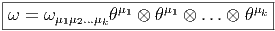

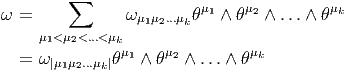

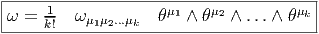

Une forme extérieure ω d’ordre k peut s’écrire de trois façons possibles. Tout d’abord, on peut la considérer comme un tenseur k fois covariant, et , à ce titre, on peut la décomposer (existence et unicité) sur la base des tenseurs d’ordre k. On peut donc écrire

La troisième écriture — de loin, la plus utilisée — est celle où on décompose la forme ω (toujours la même) sur la famille génératrice des formes extérieures θμ1 ∧θμ1 ∧…∧θμk mais sans ordonner les indices ! Bien entendu, pour un ensemble d’indices donnés (pour un ensemble de vecteurs de base donné), k! des monômes précédents vont être égaux (ou opposés) et il faudra “corriger” le développement de ω en rajoutant un 1∕k! devant l’expression. Ainsi donc,

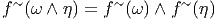

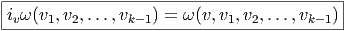

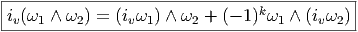

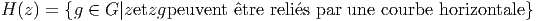

Soit E un espace vectoriel et Λ(E*) l’algèbre extérieure sur son dual. Nous avons défini précédemment le produit extérieur, qui est une loi de composition interne à l’algèbre extérieure. Au contraire, l’opération que nous allons maintenant définir, le produit intérieur n’est pas un produit au sens usuel du terme, en effet, il associe, à la donnée d’une forme extérieure ω d’ordre k (un élément de Λk(E*)) et d’un vecteur v (un élément de E) une autre forme différentielle, mais maintenant d’ordre k - 1, c’est à dire un élément de Λk-1(E*). Cette nouvelle forme est simplement obtenue en “contractant” ω et v, plus précisément, en écrivant

-=-ω(v,v1,v2,...,vk--1)-](source40x.png)

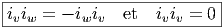

Il résulte de l’antisymétrie des formes extérieures que deux opérations iv et iw anticommutent, en particulier, le carré de l’opération iv est nul :iviwω = -iwivω et ivivω = 0, ce qu’on écrit simplement

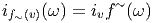

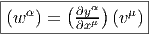

Soit f~ un endomorphisme de l’espace vectoriel E et soit f~ l’endomorphisme dual (aussi appelé transposé). Rappelons ce que cela signifie : f~ est une application linéaire de E dans E et f~ est une application linéaire du dual E* dans lui-même définie comme suit : soient v ∈ E et θ ∈ E*, alors f~(θ)(v) = θ(f ~(v)), c’est à dire encore f~(θ) = θof ~. On peut alors vérifier aisément que

et f* = f~ =

et f* = f~ =  . Notons pour finir que la notation f

~ est en

général inutile dans le cas des espaces vectoriels puisqu’on peut écrire tout

simplement f = f~, mais dans le cas des variétés, nous verrons que f≠f~≠f~ !

. Notons pour finir que la notation f

~ est en

général inutile dans le cas des espaces vectoriels puisqu’on peut écrire tout

simplement f = f~, mais dans le cas des variétés, nous verrons que f≠f~≠f~ !

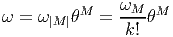

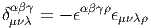

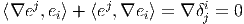

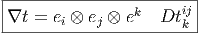

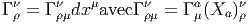

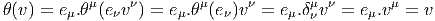

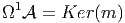

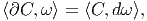

Nous avons déjà défini la notion de vecteur au point P d’une variété différentiable M ainsi que la notion de champ de vecteurs. L’ensemble des vecteurs au point P se notant TP M, l’ensemble de tous les vecteurs (le fibré tangent) se notant TM et l’ensemble des champs de vecteurs se notant ΓTM, on obtient, par dualité, les notions qui suivent. Tout d’abord l’espace vectoriel dual de TP M se note TP *M ; ses éléments sont donc des formes extérieures de degré 1, ou plus simplement, des “1-formes” . L’ensemble T*M, baptisé fibré cotangent, est l’ensemble de toutes les 1-formes, lorsque le point P décrit M, c’est-à-dire T*M = ∪ p∈MTP *M.

Une forme différentielle (en degré un) est tout simplement un champ de formes extérieures, c’est-à-dire une application qui à tout point P ∈ M associe une forme extérieure en ce point. Nous verrons un peu plus loin la raison d’être de cette terminologie. L’ensemble des formes différentielles de degré 1 peut se noter ΓT*M ou Ω1M.

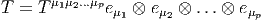

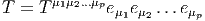

Toutes les constructions algébriques du paragraphe précédent (tenseurs et

formes extérieures sur un espace vectoriel) sont en particulier valables ici

puisqu’on peut choisir comme espace vectoriel, l’espace vectoriel tangent au point

P, c’est-à-dire TP M. Les tenseurs p fois contravariants, q fois covariants au point

P sont donc des éléments de (TP M)⊗p ⊗ (T

P *M)⊗q. Si on considère tous les

tenseurs de ce type (c’est-à-dire qu’on effectue la réunion de ces espaces lorsque

P décrit M) on obtient (TM)⊗p ⊗ (T*M)⊗q et on peut bien entendu

considérer des champs de tenseurs de ce type, dont l’ensemble constitue

Γ (TM)⊗p ⊗ (T*M)⊗q

(TM)⊗p ⊗ (T*M)⊗q .

.

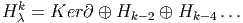

Le cas particulier des tenseurs complètement antisymétriques est particulièrement intéressant. On notera Λ(TP M)* = ⊕ kΛk(T P M)* l’algèbre extérieure sur le dual de l’espace vectoriel TP M et Λ(T*M) = ∪ p∈MΛ(TP M)*.

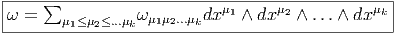

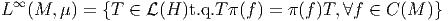

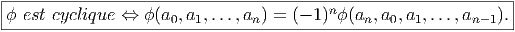

Les formes différentielles de degré q sont des “sections” de Λq(T*M) c’est-à-dire des champs de formes extérieures de degré q. Leur ensemble peut se noter, bien entendu, ΓΛq(T*M). Lorsque q = 1, on a Λ1(T*M) = T*M. Pour alléger la notation, on décide de poser Ωq(M) = ΓΛq(T*M). On sait que q ne peut pas être trop grand ; plus précisément 0 ≤ q ≤ n avec n = dim M. Attention, ne pas confondre la dimensionalité de Λ(TP M)* – qui est 2n – et celle de ΩM = ⊕q=0nΩqM, qui est infinie. Notons que les éléments de Ω∘M sont simplement les fonctions sur M c’est-à-dire Ω0M = C∞(M). Nous avons déjà étudié les propriétés du produit extérieur et il n’y a rien à rajouter ici : le produit extérieur α ∧ β de deux formes différentielles α et β est obtenu en “globalisant” la définition déjà connue pour chaque point P de M.

ΩM, munie des opérations de multiplication par un scalaire, d’addition et de produit extérieur, devient ainsi une algèbre. Cette algèbre n’est pas commutative mais elle est commutative graduée puisque α∧β = (-1)#α#ββ ∧α où #α désigne le degré de α. On appelle cette algèbre algèbre de De Rham des formes différentielles.

Pour ce qui est de l’écriture locale d’une forme différentielle, il n’y a pas grand-chose à rajouter non plus puisque nous savons déjà décomposer une forme extérieure sur une base de l’espace vectoriel TP *M. Le seul problème qui se pose est de savoir comment la base en question varie avec le point P.

Soient xμ(P) les coordonnées de P dans une carte locale. On sait que l’ensemble des vecteurs eμ = ∂ __ ∂xμ fournit le repère naturel associé à cette carte, c’est-à-dire que {eμ} est une base de l’espace tangent en tout point d’un voisinage de P.

On désignera par {dxμ} la base duale correspondante et on écrira avec des

indices “en haut” {eμ = dxμ}. On peut, si on veut, “visualiser” dxμ par “un petit

accroissement” , mais ceci présente un intérêt purement psychologique ; en effet

dxμ est défini par dualité et donc par la relation ⟨dxμ, ∂__

∂xν⟩ = δνμ. De la même

façon qu’on avait un repère naturel  associé aux coordonnées xμ, on a donc

aussi un corepère naturel {dxμ}.

associé aux coordonnées xμ, on a donc

aussi un corepère naturel {dxμ}.

Dans le cas de l’espace tangent, nous avons défini la notion de repère mobile {eα} (qui était issu de ∂ __ ∂xμ par changement de base arbitraire), nous aurons donc aussi un corepère mobile {eα} défini, en chaque point P de la carte, comme la base duale de {eα}, c’est-à-dire ⟨eα, e β⟩ = δβα.

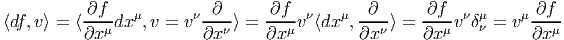

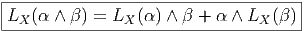

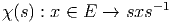

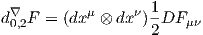

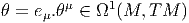

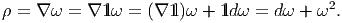

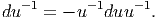

Venons-en maintenant à la notion de différentielle proprement dite. Pour ce qui est des fonctions (0-formes), on pose bien entendu

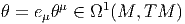

La 1-forme df peut être évaluée sur le champ de vecteurs v = vμ ∂ __ ∂xμ. On obtient

![|-------------|

|⟨df, v⟩ = v[f ]|

---------------](source54x.png)

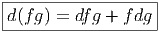

La règle de Leibniz usuelle pour la différentielle d’un produit de deux fonctions, à savoir

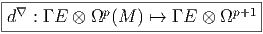

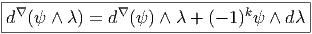

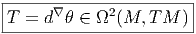

Nous allons généraliser aussi bien la définition de d que la règle de Leibniz à des formes différentielles de degré supérieur.

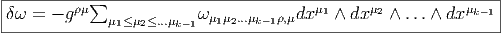

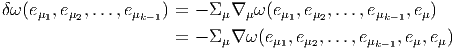

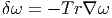

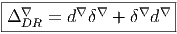

Soit ω une k-forme différentielle ; on va définir un opérateur d qui, appliqué à ω, crée une (k + 1)-forme. Cet opérateur est désigné sous le nom de différentielle extérieure ou différentielle de De Rham.

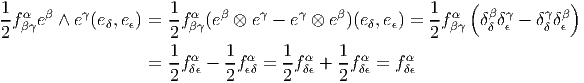

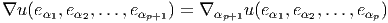

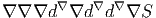

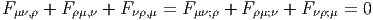

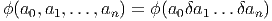

Définition 1. La forme différentielle dω peut se définir directement par son action sur tout (k + 1)-uplet {v1,v2,…,vk+1} de champs de vecteurs, en posant

![k+1

∑ i+1

dω (v1,v2,...,vk+1 ) = (- 1) vi[ω(v1,...,^vi,...,vk+1)]

i=1 ∑

+ (- 1)i+jω([vi,vj],v1,...,^vi,...,^vj,...,vk+1)

i≤i≤j≤k+1](source56x.png)

Cette définition possède un intérêt pratique certain. Pour se rappeler des signes, on peut signaler le moyen mnémotechnique suivant : le premier type de termes s’obtient en faisant passer les vecteurs vi devant ω et en comptant un signe “-” chaque fois que vi “traverse” un des autres vecteurs ; le second type de terme s’obtient en choisissant une paire vi,vj et en la faisant passer en position 1 et 2 de la forme ω, tout en utilisant l’antisymétrie de ω lorsqu’on effectue des transpositions. On remplace alors la paire (vi,vj) par son crochet [vi,vj] et on multiplie le tout par un signe -1.

Exemple 1 : Soit f une 0-forme, c’est à dire une fonction sur M. La définition ci-dessus conduit à

![df(v) = v[f]](source57x.png)

Exemple 2 : Soit ω, une 1-forme, alors

![d ω(u,v) = u (ω (v)) - v (ω(u)) - ω([u,v])](source58x.png)

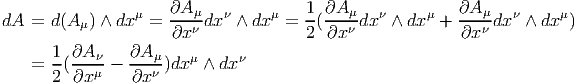

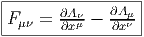

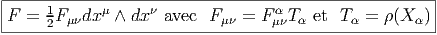

Le lecteur aura reconnu, dans le cas de la dimension 4, l’expression du champ électromagnétique (le tenseur F ) en terme du (quadri) potentiel vecteur ω. Soit dit en passant, il faut incorporer le troisième terme (l’évaluation de ω sur le commutateur [u,v]) lorsqu’on veut exprimer le champ F = dω dans un repère quelconque.

Exemple 3 : Soit ω, une 2-forme, alors

![dω(x,y, z) = x(ω (y, z)) - y(ω (x,z)) + z(ω(x,y))

- ω([x,y],z) - ω([y, z],x ) + ω ([x, z],y )](source59x.png)

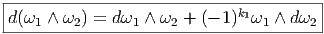

En utilisant la définition de d, donnée ci-dessus, on montre immédiatement que, si ω1 ∈ Ωk1 et ω 2 ∈ Ωk2, alors

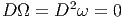

De la même façon, on montre que

Les deux propriétés ci-dessus sont absolument fondamentales et peuvent même servir à définir l’opérateur d lui même.

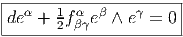

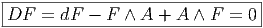

Définition 2. d est l’unique opérateur (application linéaire) de ΩkM dans Ωk+1M tel que, pour tout k, ω 1 ∈ Ωk1, ω 2 ∈ Ωk2, k = k 1 + k2, on ait d(ω1 ∧ ω2) = dω1 ∧ ω2 + (-1)k1ω 1 ∧ dω2 et d2 = 0. En d’autre terme d étend la définition usuelle de différentiation des fonctions en une dérivation graduée de carré nul de l’algèbre ΩM. En physique, si ω désigne le quadri-potentiel vecteur, alors, F = dω obéit automatiquement à l’équation dF = 0, puisque d2 = 0. Ceci nous donne donc la moitié des équations de Maxwell (les équations sans source).

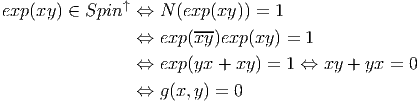

Il existe une troisième définition possible de l’opérateur d, définition qui est également d’un intérêt pratique certain. La voici :